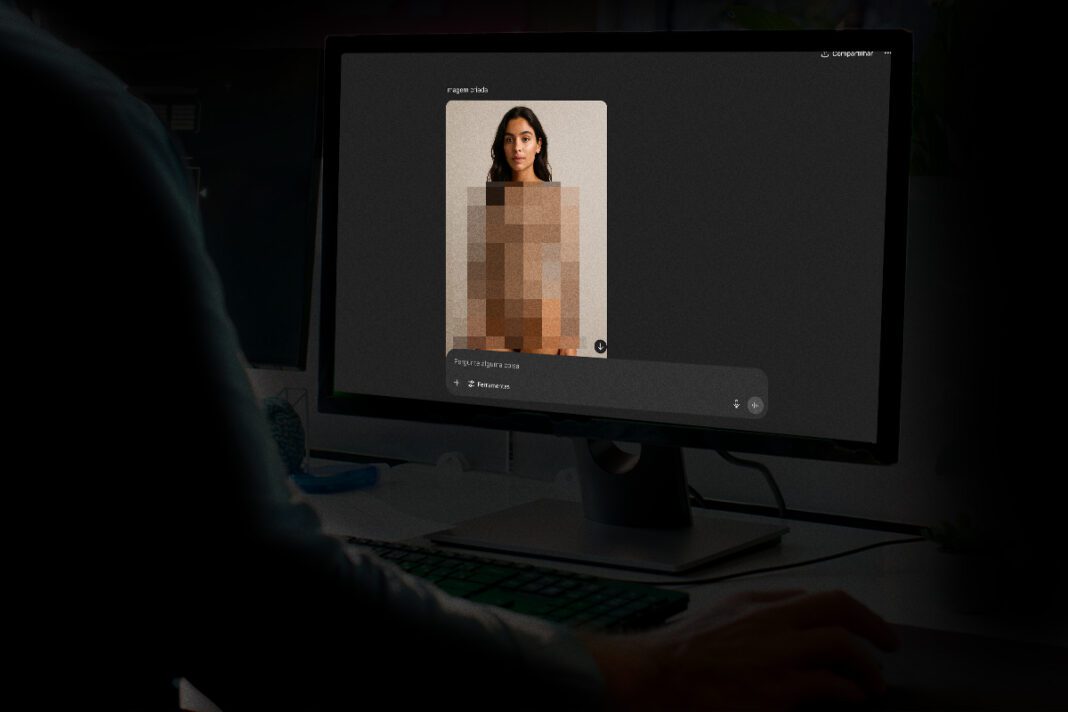

O caso de pelo menos 17 alunas do ensino médio do Colégio Santa Maria, em Belo Horizonte (MG), que denunciaram que tiveram fotos manipuladas por inteligência artificial (IA) para a criação de conteúdos pornográficos trouxe preocupação ao público feminino nas redes sociais. A manipulação de imagens — conhecido como deepfake — virou um grande medo devido à grande evolução das IA em todo o mundo.

O tema chegou até a Câmara dos Deputados, que aprovou no início deste ano um projeto de lei (PL) que inclui a prática de manipulação digital e divulgação de nudez ou ato sexual falso gerados por IA no Código Penal. O texto ainda precisa ser votado no Senado.

Se virar lei, o crime poderá ser punido com reclusão de 2 a 6 anos e multa, caso o fato não constitua outro crime ainda mais grave. A pena será aumentada de 1/3 até a metade se a vítima for mulher, criança, adolescente, pessoa idosa ou com deficiência. Quando o crime for cometido com a disseminação em massa por meio de redes sociais ou plataformas digitais, a pena será aumentada de 1/3 ao dobro.

Caso colégio Santa Maria (MG)

- Pelo menos 17 alunas do ensino médio do Colégio Santa Maria, em Belo Horizonte (MG), denunciaram que tiveram fotos manipuladas por inteligência artificial (IA) para criação de conteúdos pornográficos.

- A denúncia foi feita pela influenciadora Ive Moreira, de 21 anos, irmã de um ex-aluno da instituição, em um vídeo no TikTok.

- Segundo Moreira, há mais de um ano, alunos da escola vêm utilizando fotos das vítimas, publicadas nas redes sociais, para gerar imagens íntimas falsas, divulgadas em grupos no Telegram e WhatsApp. “Qualquer um pode acessar esses conteúdos”, afirmou.

- A influenciadora ainda diz que as vítimas, com idades entre 12 e 17 anos, teriam seus nomes vinculados às imagens, que circulavam entre os estudantes.

- Além disso, há indícios de que o material estava sendo vendido em um dos grupos por um aluno da mesma escola.

A advogada especialista em direito penal e digital, Jéssica Marques, explica que a vítima de uma foto reproduzida por IA sem sua autorização deve colher todas as provas possíveis a fim de identificar o fraudador. O primeiro passo é realizar o registro da foto alterada e do endereço URL. “Caso a foto tenha sido extraída de suas redes socais, deve verificar a lista das pessoas que visualizaram e anexar aos documentos que servirão de acervo probatório para identificar o criminoso”, esclarece.

Para a especialista, é importante que os usuários das redes sociais não divulguem e não repassem informações ou dados pessoas e, tampouco, atendam ligações de chamada de vídeo. Além disso, restringir os vídeos ou imagens divulgadas pelas redes é interessante para evitar a possibilidade de serem utilizadas para reproduzir algo por meio de inteligência artificial.

Por fim, Jéssica Marques destaca a necessidade da denúncia da imagem reproduzia indevidamente, bem como a notificação da plataforma para que auxilie na identificação do divulgador da foto alterada. “Além disso, a vítima deve registrar uma ocorrência na delegacia especializada para que haja a investigação devida”, frisa.

VEO 3

Vídeos gerados por IA têm viralizado cada vez mais nas redes sociais, confundindo internautas com situações que parecem verdadeiras. As produções que mais repercutem são feitas com o Veo 3, um modelo de IA lançado pelo Google, que permite adicionar efeitos sonoros, ruídos ambientes e até diálogos solicitados pelos usuários.

Ao ser questionado pelo reportagem sobre o uso da IA para produção de conteúdo explícito, o Google informou que suas políticas restringem o uso de nossos modelos para atividades sexualmente explícitas, violentas, odiosas ou prejudiciais, como discurso de ódio ou bullying, e para desinformação, deturpação ou atividades enganosas, incluindo fraudes, golpes ou outras ações enganosas como a falsificação de identidade.

“É importante ainda que as pessoas possam saber a origem do conteúdo online. Nossa tecnologia SynthID insere marcas d’água digital em todos conteúdos gerados por modelos de IA generativa do Google. Como uma etapa adicional para ajudar as pessoas a identificar conteúdo gerado por IA, estamos adicionando uma marca d’água visível a todos os vídeos, exceto aos vídeos gerados por membros Ultra no Flow, nossa ferramenta de IA para cineastas”.

IA e consequências

Ao Metrópoles, o professor de direito da Universidade de Brasília (UnB), Alexandre Veronese, expressou preocupação com a suficiência das leis atuais no combate aos crimes cibernéticos no Brasil.

“Apesar de a legislação brasileira ser aderente aos termos da Convenção de Budapeste, o país enfrenta dois graves problemas jurídicos”, afirma Veronese. Ele defende uma revisão do Código Penal e do Código de Processo Penal para aprimorar a tipificação dos crimes e os meios processuais, permitindo uma adesão plena à Convenção de Budapeste e seus dois protocolos adicionais, um sobre racismo e xenofobia, e outro sobre cooperação internacional em matéria de provas.

O segundo ponto crítico levantado por Veronese é a integração dos crimes cibernéticos com a proteção de dados pessoais. O professor destaca que a Lei Geral de Proteção de Dados Pessoais (LGPD) exclui sua incidência em investigações e processos criminais, segurança pública, defesa nacional e segurança do Estado. Contudo, “a Constituição Federal considera a proteção dos dados pessoais um direito fundamental, incidindo sobre todas as áreas”, ressalta. Essa lacuna legal gera dúvidas e riscos jurídicos desnecessários, enquanto outros países e a União Europeia já resolveram questões semelhantes. Para Veronese, é “imperativo que o Brasil resolva o tema”, como já apontado pelo Supremo Tribunal Federal (STF) na ADC 51.

Por fim, Alexandre Veronese aborda o avanço tecnológico da IA e suas implicações para a criminalidade. Ele observa que, embora a IA possa ter usos positivos, como otimizar processos de trabalho, também pode impulsionar ações maliciosas, como fraudes e outras violações de direitos, à medida que se torna mais barata e acessível. O professor sugere a criação de agravantes penais e o aumento de indenizações para crimes cometidos com o auxílio de IA, a fim de desincentivar seu uso em atividades ilegais. Entretanto, adverte que “vedar seu uso ou criar desincentivos fortes – sem bons critérios – contra sua disseminação, em geral, será muito improdutivo e, talvez, até ineficaz”, dada a realidade da ferramenta.